“在摩尔定律失效的当下,如果我们真想提高计算机性能,‘黄氏定律’就是一项重要指标,且在可预见的未来都将一直适用。”在近日举办的GTC中国峰会上,英伟达首席科学家Bill Dally做出上述发言。

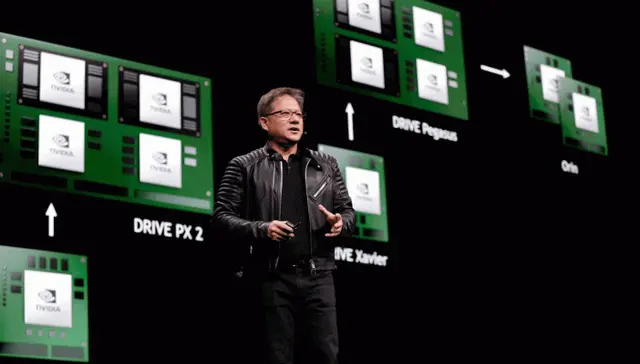

所谓黄氏定律,是以英伟达首席执行官黄仁勋(Jensen Huang)名字命名的定律,其预测GPU将推动AI性能实现逐年翻倍。目前来看,虽然或多或少受到硬件与软件影响,但黄氏定律将稳定发展,小至个人数码产品中的脸部或语音识别,大至自动驾驶汽车、数据中心等,都受益于黄氏定律。

在半导体的开发竞争中,业界普遍认为,以每两年2倍的速度发展的摩尔定律即将走到极限。在芯片主战场转向于AI领域的背景下,由英伟达提出的黄氏定律得到重视,显示英伟达在AI计算领域的领先地位。

当前AI计算无处不在,进一步向个人设备、边缘领域拓展。以智能手机为例,内置芯片搭载的神经网络引擎就为各项机器学习任务奠定了基础,如面部识别、自然语言理解、物体追踪与规避、手势和文本识别等。

“在整个GPU芯片设计历史过程中,随着工艺的发展,我们自然而然会放进去更多的计算单元。”英伟达中国区工程和解决方案高级总监赖俊杰告诉界面新闻记者。同时,英伟达依靠架构上的创新,从而使GPU发展速度和性能提升呈现几倍、甚至几十倍的结果。在GPU市场,英伟达GPU芯片的应用早已扩展到了游戏、图形计算之外,在数据中心的加速计算、AI取得主要市场份额。

不过,虽然基本上是以AI为核心,但系统运作时仍然少不了CPU参与。而Bill Dally坦承,当工程师大幅提升某部分的运算时,其他无法再加快的部分就会成为瓶颈。

Bill Dally于2009年加入英伟达,此前担任斯坦福大学计算机科学系主任,致力于数据科学、人工智能和图形学的研究,拥有120多项专利。在英伟达,Bill Dally负责领导一支200多人的科学研究团队。

Bill Dally称,英伟达的目标是通过GPU技术的改进,每年将使AI推理性能成倍提升。在GTC大会上,英伟达推出一款超高能效加速系统MAGNet,可以让AI推理能力达到每秒100万亿次的效率,比目前的商用芯片高出一个数量级。

“数据传输正是当今芯片中最耗能的环节,MAGNet采用了一系列新技术来协调并控制通过设备的信息流,从而最大限度地减少数据传输。”Bill Dally介绍称,MAGNet也是黄氏定律得以推动的例子之一。

另一方面,Bill Dally带领的英伟达研究团队也正在研究更快速的光链路取代现有IT系统内的电气链路。其中,一种名为“密集波分复用”的技术,有望在仅一毫米大小的芯片上实现Tb/s级别数据传输,是当前互连密度的十倍以上。

目前,英伟达的研究团队与哥伦比亚大学合作,探讨如何利用电信供应商在其核心网络中所采用的技术,通过一条光纤来传输数十路信号。

不过,市场虽然对黄氏定律给予肯定,但与摩尔定律相比,黄氏定律具体发展步调仍难以确定。黄氏定律所提到的运算处理能力,其实无法推而广之,适用于各种应用情境中。人工智能研究组织Open AI就表示,以典型的AI影像识别测试为例,虽然笼统来看,AI“性能”每年可增加一倍,但要如何对“性能”达成共识,仍然是一项挑战。

简体中文

简体中文